Teilprojekt 3: Optische Unterwasser-3D-Messtechnik

| Teilprojektleiter | Prof. Dr.-Ing. habil. Thomas Luhmann |

| Teilprojektmitarbeiter | Robin Rofallski, M.Sc. |

| Teilprojektvolumen | 241.727 € |

| Fördermittelgeber | Nds. Ministerium für Wissenschaft und Kultur - VW-Vorab/Wissenschaft für nachhaltige Entwicklung |

| Teilprojektlaufzeit | 01/2017 bis 06/2021 |

Optische Messtechnik unter Wasser, insbesondere Photogrammetrie, stellt durch viele Faktoren eine große Herausforderung dar und ist damit gleichzeitig ein aktiver weltweiter Forschungsgegenstand. Durch die limitierten Sichtverhältnisse müssen aufgenommene Bilddaten oftmals zunächst mittels Bildverarbeitung verbessert werden, um sie für eine Auswertung aufzuarbeiten. Auch stellt die Strahlbrechung an den Medienübergängen von Luft zu Glas zu Wasser eine besondere Problematik bei der Kamerakalibrierung unter Wasser dar. Durch diese physikalischen Medieneigenschaften werden Objekte stark verzerrt abgebildet, so dass photogrammetrische Standardverfahren erweitert werden müssen.

In diesem Teilprojekt wird ein kamerabasiertes Multi-Sensor-System zur Positionierung, Navigation und Kartierung von unbemannten Unterwasserfahrzeugen entwickelt. Besondere Herausforderungen sind neben den vorgenannten optischen Eigenschaften des Wassers auch die limitierten Platzverhältnisse, welche spezielle Lösungen für Stromversorgung, Kommunikation und Datenverarbeitung erfordern.

Optisches Multi-Sensor-System

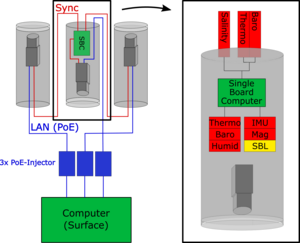

Im Teilprojekt wurde ein optisches Multi-Sensor-System, bestehend aus drei automatisierbaren, hochauflösenden Kameras und zusätzlicher Low-Cost-Sensorik (Inertiale Messeinheit, Short Baseline Positionierung, Thermometer, Barometer, Leitfähigkeitssensor) entwickelt [1, 2]. Aufgrund hoher Datenmengen der Kameras wurde die Daten- und Stromverbindung über ein Ethernetkabel zu einem Rechner an der Oberfläche realisiert. Zur Positionierung wurden drei Kameras mit vor- und rückblickendem Sichtfeld am ROV angebracht und mithilfe verschiedener Auswerteverfahren verarbeitet, sodass in Kombination mit den zusätzlichen Sensoren eine stabile Position geschätzt werden kann. Das Dreikamerasystem bietet den Vorteil, eine robustere geometrische Basis zu schaffen, als es bei vergleichbaren Systemen mit zwei (Stereo) Kameras der Fall ist, um so zeitabhängige Driften zu vermeiden. Das Kamerasystem ist modular aufgebaut und lässt sich flexibel sowohl in den BlueROV2 als auch in beliebige andere Unterwasserplattformen integrieren (siehe Abbildungen 1 und 2). Eine eigens entwickelte Auslösung und zentrale Datenverwaltung auf einem Einplatinenrechner gewährleisten einerseits die Synchronisierung der drei Kameras untereinander und bietet andererseits eine Schnittstelle zur Integration weiterer Sensoren. Die bislang kabelgebundene Variante soll perspektivisch, auch über das Vorhaben hinaus, durch eine kabellose Variante ersetzt werden, um höhere Flexibilität in Anwendungen und Integration in andere Plattformen zu erreichen.

Kalibrierung

Simulationen zur erwartbaren Genauigkeit eines Mehrkamerasystems wurden in [3, 4] publiziert. Besonderer Schwerpunkt der Analysen und Simulationen war der Einfluss einer Mehrmedienkalibrierung für unterschiedliche Kameraanordnungen. Auch wurde diskutiert, welche Genauigkeit von der Vernachlässigung des Mehrmedienfalls zu erwarten wäre. Es konnte hier gezeigt werden, dass für mittlere bis geringe Genauigkeitsanforderungen und homogene Objektdistanzen auch Standardauswerteverfahren hinreichende Qualitäten erzeugen. Sobald Objektdistanzen stark variieren (einige Dezimeter bis mehrere Meter) oder höchste Genauigkeitsanforderungen < 1 mm herrschen, ist eine explizite Modellierung des Mehrmedienfalls unumgänglich. Weiterhin ist bei der Kalibrierung zu beachten, dass die erwartete Objektentfernung bei der in-situ Aufnahme bereits bei der Kalibrierung hinreichend abgedeckt wird, um ein vollständiges Abbild der Aufnahmesituation zu erhalten.

Mehrmedienphotogrammetrie

Zur Berücksichtigung der Strahlbrechung wurde eine Bündelausgleichung mit expliziter Modellierung des Mehrmedienfalls nach dem Ray-tracing-Ansatz von Mulsow [5] entwickelt. Die Software wurde objektorientiert in C++ geschrieben und fügt sich in die bestehende Softwarebibliothek am IAPG nahtlos ein. Durch Nutzung einer leistungsfähigen Optimierungsbibliothek [6], konnte die ansonsten sehr hohe Rechenzeit maßgeblich reduziert und so auch große Gleichungssysteme mit mehreren tausend Beobachtungen und Unbekannten in wenigen Minuten (Mehrmedienfall) oder Sekunden (Standardmodell) gelöst werden. Derzeit wird eine Publikation zum Thema in einer Fachzeitschrift vorbereitet. Hier wird die spezielle Bündelausgleichung ebenso wie eine innovative Weiterentwicklung des Ansatzes nach Mulsow thematisiert. Die Publikation erscheint voraussichtlich im vierten Quartal 2021. Die Bündellösung ist weiterhin modular aufgebaut, verschiedene Kameramodelle können integriert werden und die Anwendung ist nutzerfreundlich dokumentiert.

Wrackuntersuchung in der Ostsee

Die Erprobung in realen Gewässern fand in Gewässern mit unterschiedlichen optischen Eigenschaften statt. Zunächst wurden Teile des Kamerasystems auf ein ROV des Bundesamts für Seeschifffahrt und Hydrographie portiert und zur 3D-Aufnahme eines versunkenen Kutters in der Neustädter Bucht (Ostsee) eingesetzt [7]. Teile des Wracks konnten von beiden Messsystemen erfasst und die Daten fusioniert werden. Es zeigt sich, dass die Daten der photogrammetrischen Punktwolke ein deutlich höhere Auflösung, als jene des Echolotes. Weiterhin können auch die Farbinformationen eine weitere Informationsquelle darstellen. Aufgrund der schwierigen Navigationsverhältnisse unter Wasser und dem sequentiellen Charakter einer Bildaufnahme mittels ROV bieten die Echolotdaten einen enormen Zugewinn hinsichtlich einer global orientierten Punktwolke und einer konstanten Genauigkeit im Dezimeterbereich. Diese kann ideal durch die photogrammetrischen Beobachtungen ergänzt werden.

Künstliche Riffe im indischen Ozean

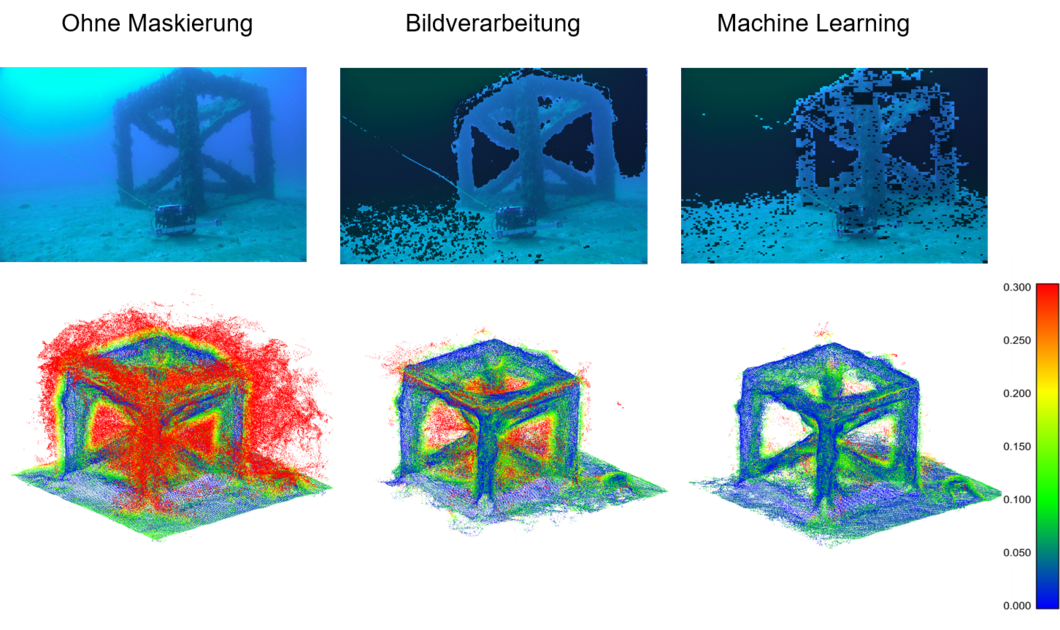

Weiterhin wurde das Gesamtsystem mit dem genutzten BlueROV2 in klaren Gewässern des indischen Ozeans eingesetzt. In Kooperation mit der Curtin University in Perth wurden hier künstliche Riffe untersucht und vermessen [2]. Es konnten 3D-Rekonstruktionen der Riffe und deren biologischer Bewuchs erstellt und zusätzlich Verfahren zur automatisierten Maskierung in Structure-from-Motion-Auswertungen unter Wasser entwickelt werden (s. Abb. 3). Diese fußen auf verschiedenen Grundprinzipien, wie der digitalen Bildverarbeitung und Machine Learning als Teil der künstlichen Intelligenz. Mittels Maskierungen konnten stark verrauschte dichte Punktwolken ohne manuellen Eingriff gefiltert werden.

Literatur

[1] Rofallski, R.; Luhmann, T. (2018): Fusion von Sensoren mit optischer 3D-Messtechnik zur Positionierung von Unterwasserfahrzeugen. In: Hydrographie 2018. Trend zu unbemannten Messsystemen. DVW-Schriftenreihe, Band 91. 1. Auflage. Augsburg: Wißner-Verlag (Schriftenreihe des DVW, Band 91), S. 223–234.

[2] Rofallski, R.; Tholen, C.; Helmholz, P.; Parnum, I.; Luhmann, T. (2020a): Measuring Artificial Reefs Using a Multi-Camera-System for Unmanned Underwater Vehicles. In: Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci. (XLIII-B2-2020), S. 999–1008. DOI: 10.5194/isprs-archives-XLIII-B2-2020-999-2020.

[3] Kahmen, O.; Rofallski, R.; Conen, N.; Luhmann, T. (2019): On scale definition within calibration of multi-camera systems in multimedia photogrammetry. In: Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci. XLII-2/W10, pp. 93–100. DOI: 10.5194/isprs-archives-XLII-2-W10-93-2019.

[4] Kahmen, O.; Rofallski, R.; Luhmann, T. (2020): Impact of Stereo Camera Calibration to Object Accuracy in Multimedia Photogrammetry. In: Remote Sensing 12 (12), S. 2057. DOI: 10.3390/rs12122057.

[5] Mulsow, C. (2010): A flexible multi-media bundle approach. In: Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci. XXXVIII/5, pp. 472–477.

[6] Agarwal, S.; Mierle, K.; Others (2021): Ceres Solver. Online verfügbar unter http://ceres-solver.org.

[7] Rofallski, R.; Westfeld, P.; Nistad, J.-G.; Büttner, A.; Luhmann, T. (2020b): Fusing ROV-based photogrammetric underwater imagery with multibeam soundings for reconstructing wrecks in turbid waters. In: Journal of Applied Hydrography (116), pp. 23-31. DOI: 10.23784/HN116-03.