Interaktive Systeme

Die Arbeitsgruppe für interaktive Systeme (isg)

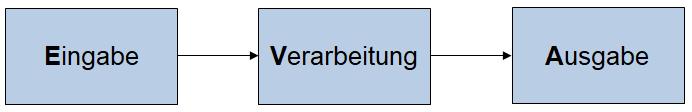

Zu Beginn der Datenverarbeitung wurden die zur Erfüllung einer Aufgabe notwendigen Schritte Eingabe, Verarbeitung und Ausgabe von einem Computersystem durchlaufen, z.B. über Tastatur, Textverarbeitungsprogramm und Drucker.

Abbildung 1: EVA-Paradigma mit sequentieller Eingabe, Verarbeitung und Ausgabe.

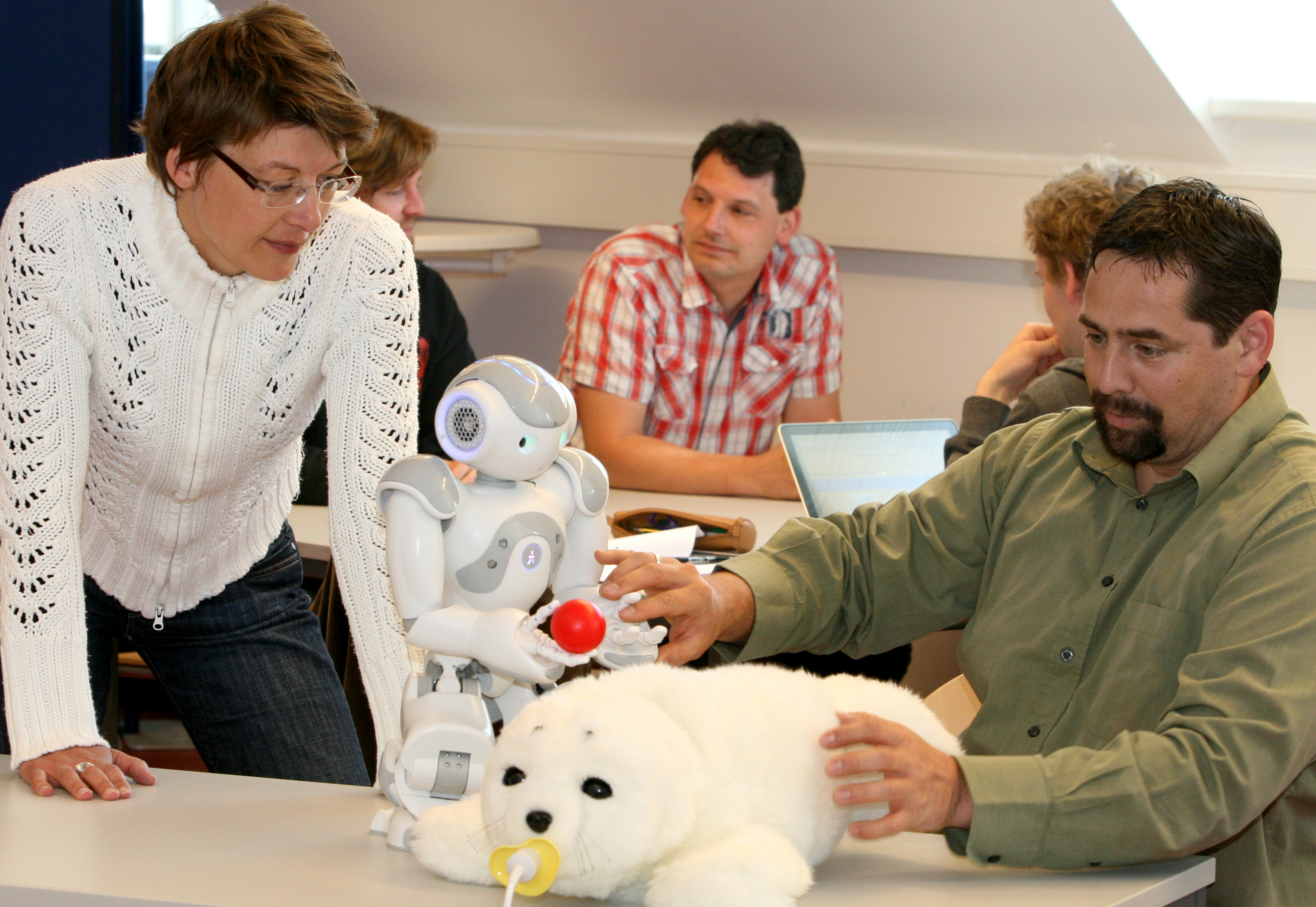

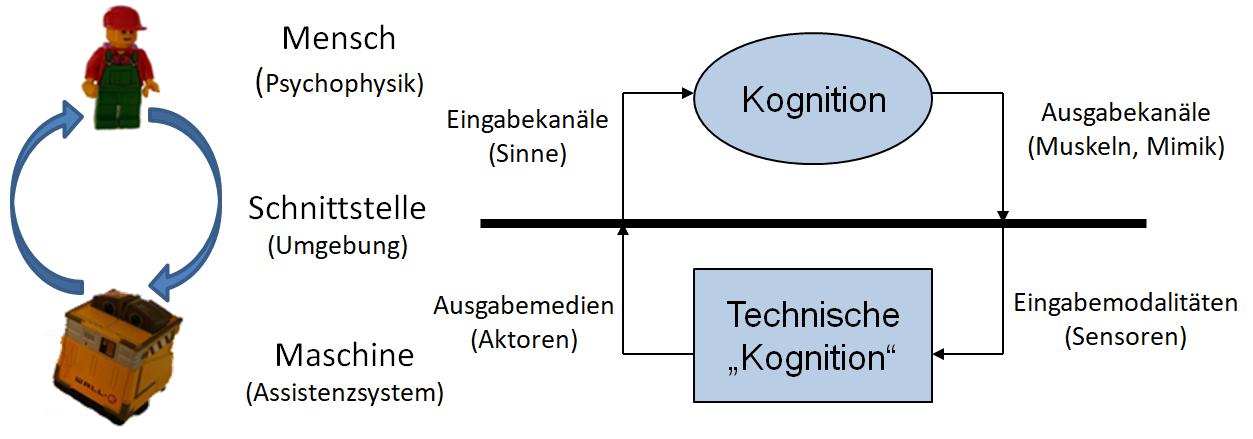

Das sogenannte EVA-Prinzip wie in Abbildung 1 dargestellt ist an sich für kleinere Aufgaben immer noch ausreichend. Komplexere Assistenzsysteme wie z.B. Serviceroboter im Haushalt oder im Arbeitsumfeld, verlangen jedoch eine kontinuierliche Verarbeitungsschleife, welche die Intentionen und Eingaben des Menschen über haptische Eingaben (Tastatur, Maus oder Touchscreen) hinaus kontinuierlich verstehen, verarbeiten und ihre Ergebnisse an den Nutzer übermitteln, wie in Abbildung 2.

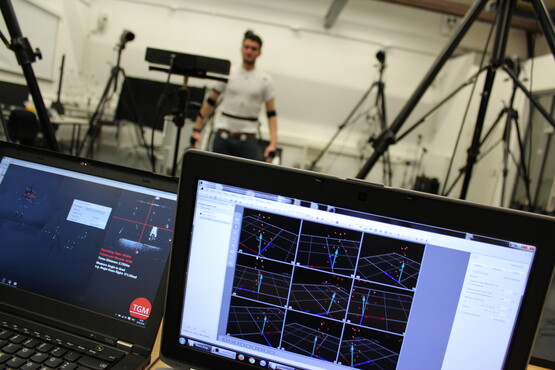

Abbildung 2: Interaktionsschleife am Beispiel einer Mensch-Roboter Kooperation

Diese Systeme müssen also interaktiv sein. Dies kann durch intelligente Sensoren und Aktoren sowie kognitive Architekturen realisiert werden, welche aus gemachten Beobachtungen Informationen ableiten und somit auch lernfähig sind. Dies setzt neben Ansätzen der künstlichen Intelligenz auch verschiedene Methoden der multimodalen Signalverarbeitung und der Mustererkennung voraus, wie z.B. Sprach- oder Gesichtserkennung. Die Erforschung und Implementierung dieser Bausteine vor dem Hintergrund von anwendungsnahen Lösungen ist somit für eine möglichst intuitive Mensch-Maschine-Schnittstelle im Fokus der Forschung der Arbeitsgruppe für interaktive Systeme.

Das Labor für interaktive Systeme (lis)

Das Labor für interaktive Systeme dient der Lehre und Forschung im Bereich der Mensch-Maschine-Interaktion und wurde im Rahmen der Neuberufung der Professur Assistive Technologien von Prof. Frank Wallhoff geplant und ausgestattet. Dabei steht die Schnittstelle, also das Zusammenspiel adaptiver und kognitiver technischer Systeme mit der komplexen menschlichen Kognition im Vordergrund. Es können Fragen zur Usability und Ergonomie adressiert werden: wie gut ist die Passung der Schnittstelle zwischen Nutzern und verwendeter Technologiekomponente? Im Labor stehen somit sowohl Geräte und Verfahren zur Modellierung von technischen Artefakten, genauer von eingebetteten Systemen bis hin zu Industrierobotern, als auch Messgeräte für Biosignale zur Vermessung und Identifikation physiologischer Parameter, z. B. Hautleitwert, Eyetracking oder EEG, zur Verfügung. Aktuell ist das Labor über die Räume W005 und W009 in der Westerstraße 10-12 verteilt. Ein Umzug und eine Verstetigung des Labors in den Räumen der Augustraße 5 stehen an.

Gerätetechnische Ausstattung

Das Labor verfügt über 4 moderne PC-Gruppenarbeitsplätze sowie 10 mobile Rechner und Platz für insgesamt bis zu 10 Personen.

Roboter:

- 1 SCITOS G5, auch als ALIAS bekannt

- 1 KUKA KR3 auf Werkbank montiert

- 12 NAO, davon ein grauer, dein oranger, fünf blaue, fünf rote

- 5 LEGO NXT Sets mit diversem Zubehör

- 8 LEGO EV3 Sets mit diversem Zubehör in separaten Sortierkästen

- 12 qFix CrashBobbys mit ausgedehntem Satz an Sensorik und Aktorik

- 2 TurtleBots mit Steuerrechnern

- RoboMow

- iRobot

- youBOT (mobile Plattform + Arm)

Biosignalmessgeräte

- gMobilab ++

- Nexus 10 MKII

- Eyeseecam Eyetracker

Diverses

- 10 ELSE Lernsets mit Arduino Boards

- 10 ELSE 2.0 Lernsets mit Raspberry Pi2 und Sensor- Aktor Kits

- weitere Kleinroboter (Arrex, Fischertechnik, ...)